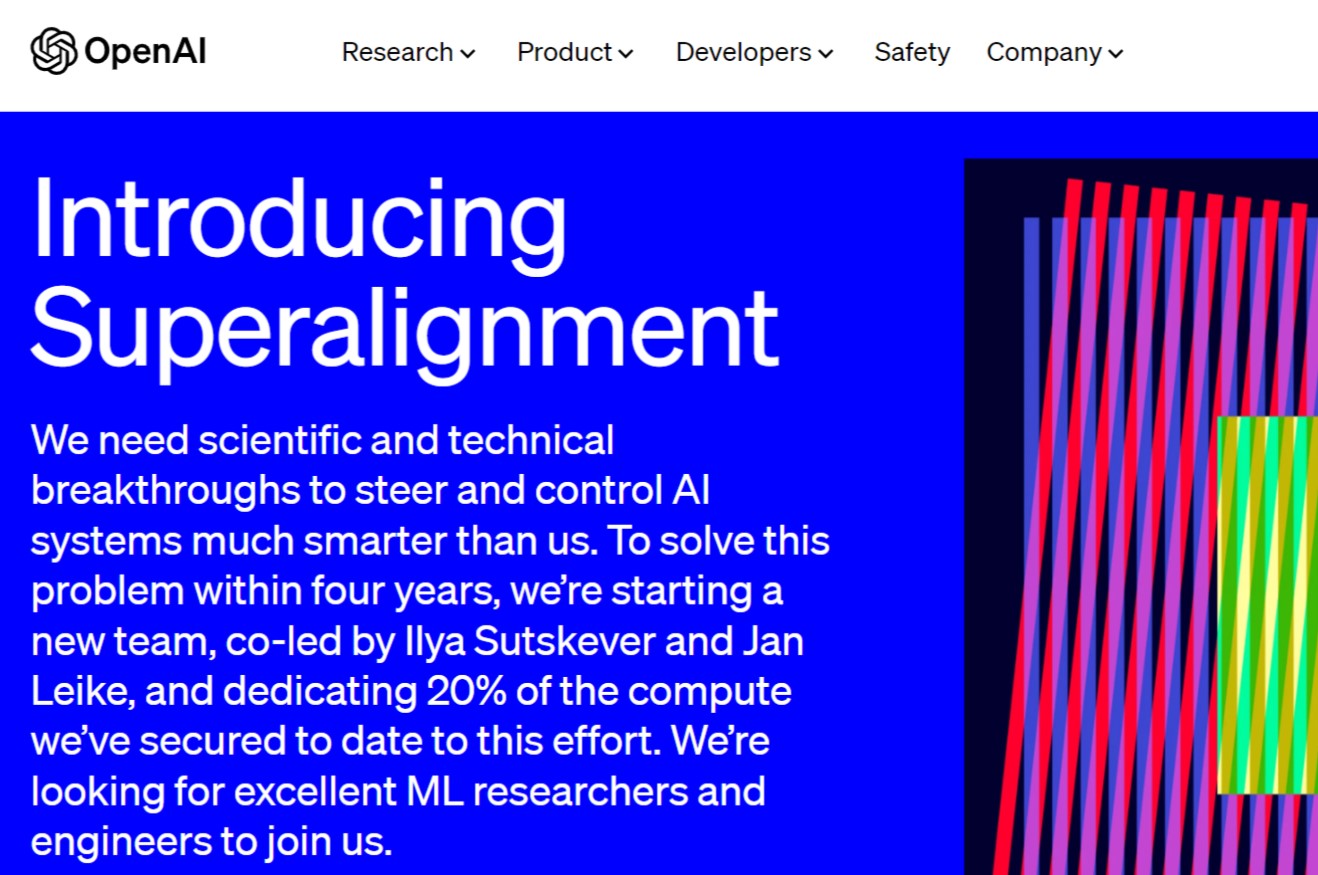

他们预测,超智能AI(即比人类更聪明的系统)可能在这个十年(2030年前)就会到来,人类将需要比目前更好的技术来控制超智能AI,因此需要在所谓的“一致性研究”方面取得突破,该研究的重点是确保人工智能对人类有益。根据他们的说法,在微软(Microsoft)的支持下,OpenAI将拿出未来四年所获算力的20%用于解决AI失控的问题。此外,该公司正在组建一个新的团队来组织这项工作,称为超级一致性团队。

这个团队的名字叫Superalignment,别管这个super,其实主要就是这个alignment。中文可以翻译成“对齐”,它是一个在自然语言处理(NLP)中很重要的术语。通常指的是在两种或多种语言的文本之间建立相互对应关系。这在机器翻译中尤其重要,例如,在英语句子和法语句子之间建立对应的词汇关系。

对于大型语言模型如GPT-4,对齐也可以指的是模型学习到的特征和人类理解的概念之间的对应关系。例如,我们希望模型在处理文本时能够对苹果这个词语的理解,与人类的理解尽可能一致。在实际应用中,这种对齐能够帮助模型更好地理解和生成文本。据悉,该团队的目标是创建一个“人类级别”的AI研究人员,然后通过大量的计算能力进行扩展。

OpenAI表示,这意味着他们将使用人类反馈来训练AI系统,训练AI系统来辅助人类评估,然后最终训练AI系统进行实际的一致性研究。我们扔给大模型一堆资料,它可能自己学会了什么是苹果,比如说苹果可能是Apple公司,也可能是砸到牛顿头上的那个东西。但是根据统计学原理,最长出现的对于苹果的概率还是它是一个水果,可以吃,很好吃等等这些概念。

但是有没有可能大语言模型理解不了?有可能,所以需要对齐。我们得让大模型跟我们人类的想法是一致的。建立一个大致达到人类水平的自动对齐系统。然后,可以使用大量算力来扩展工作,并调整超级智能。1、开发可扩展的训练方法:为了针对人类难以评估的任务提供训练方法,可以通过人工智能系统来协助评估,其他人工智能系统(可扩展的监督)。此外,OpenAI希望了解和控制其模型,将监督应用到无法监督的任务(泛化)上。

2、验证生成的模型:为了验证系统的一致性,OpenAI将自动搜索有问题的行为(稳定性)和有问题的内部结构(自动可解释性)。3、对整个对齐管道进行压力测试:可以通过故意训练未对准的模型,来测试整个安全流程,并确认技术检测到最差的未对准类型(对抗性测试)。OpenAI预计,随着对超级智能对齐了解越来越多,研究重点将会发生重大变化,可能会增加全新的研究领域。

根据他们的说法,在微软(Microsoft)的支持下,OpenAI将拿出未来四年所获算力的20%用于解决AI失控的问题。此外,该公司正在组建一个新的团队来组织这项工作,称为超级一致性团队。据悉,该团队的目标是创建一个“人类级别”的AI研究人员,然后通过大量的计算能力进行扩展。OpenAI表示,这意味着他们将使用人类反馈来训练AI系统,训练AI系统来辅助人类评估,然后最终训练AI系统进行实际的一致性研究。

超级智能将是人类发明的最具影响力的技术之一,可以帮助我们解决世界上许多难题。但超级智能的巨大力量也可能非常危险,并导致人类失去控制权,甚至灭绝人类。虽然超级智能还很遥远,但OpenAI认为,10年之内就很有可能实现。

点击收藏本站,随时了解时事热点、娱乐咨询、游戏攻略等更多精彩文章。